★Apple Homekit対応

→あいにく技術的な観点より難しいとのことで未対応です。

ということらしいです。

なので、せっかくなのでAppleHomeKitに対応させてみようと思って調べてみました。

いろいろ調べてみたところ、どうやらRTSP対応カメラと、「Homebridge」とやらをインストールして動かすサーバ用のLinuxがあればとりあえず動かせるようです。

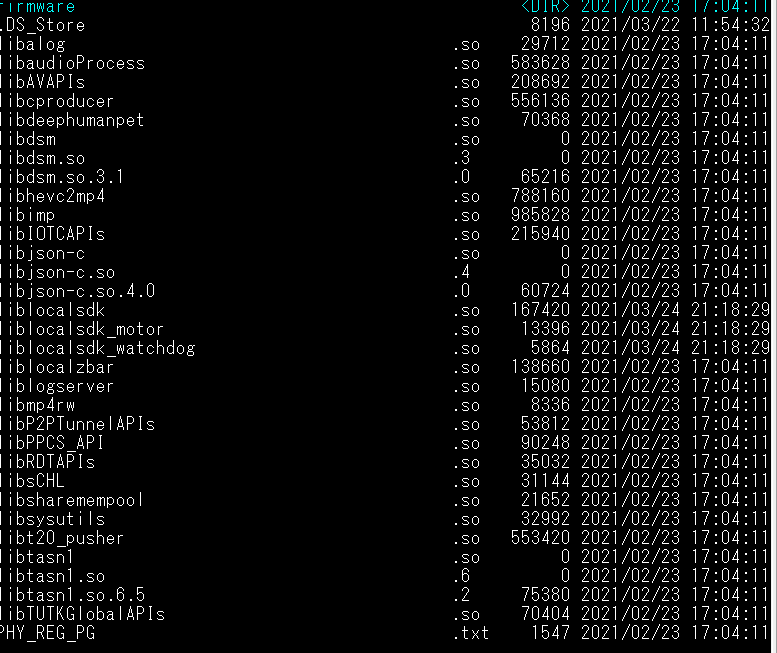

こちらの記事でまとめたように、ATOMCam2には無理やりRTSP機能は追加してあります。

外からも見えるようにするにはiPadとかAppleTVが必要、ということですが、ぶっちゃけApple製品についてはさっぱりわからないので、これらの記事を参考にしてどしどし進んでみます。

Linuxマシン、まぁRaspberry Piを使って単体で仕上げておく、のが便利な気がしますが、とりあえずは手元のハッキング用Linux環境にHomebridgeをインストールしてみます。

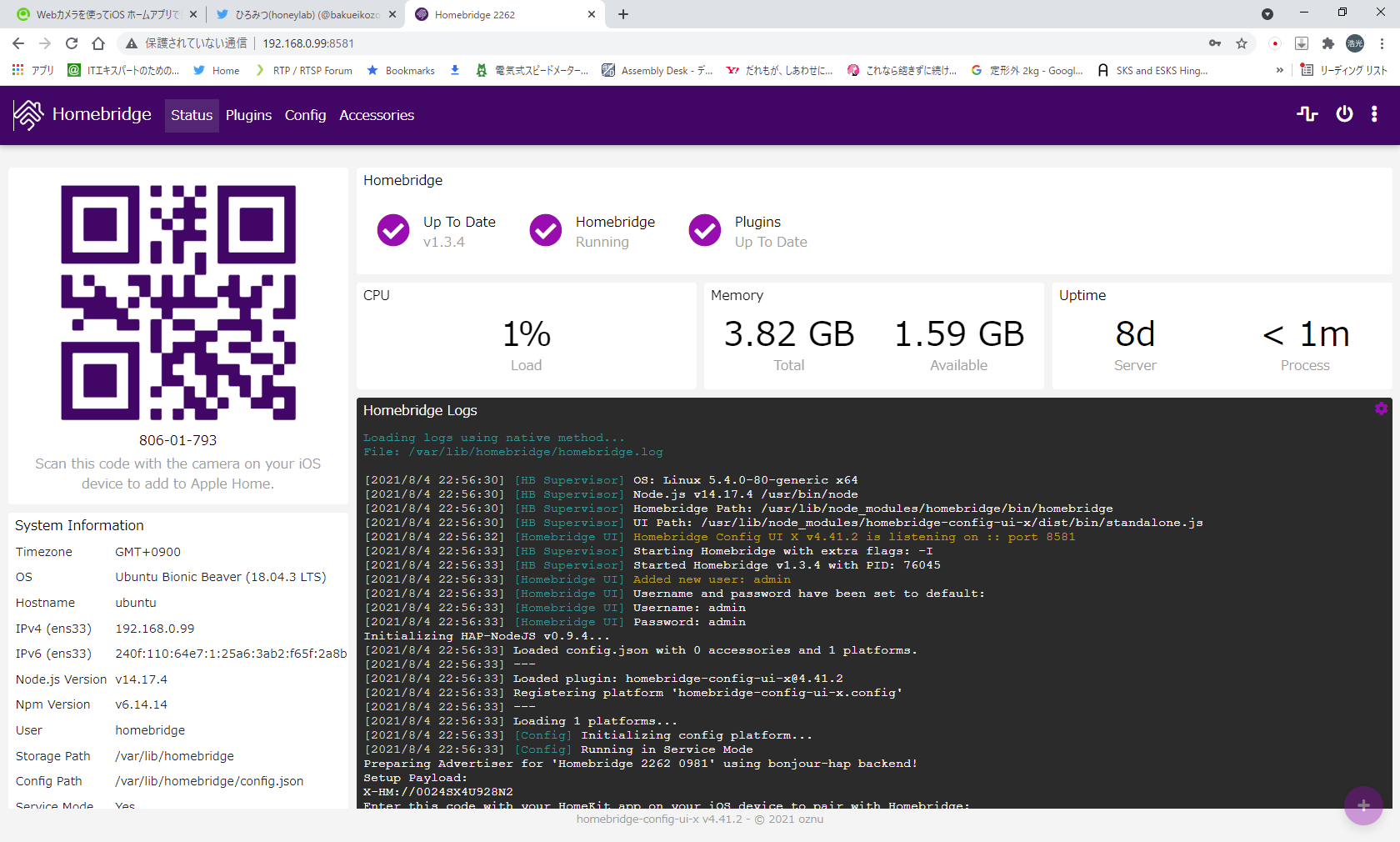

ブラウザで設定画面を開きます。なんだかかっこいいです。

さて、ここで上記のリンクにあるように「Homebridge Camera FFmpeg」をインストールします。

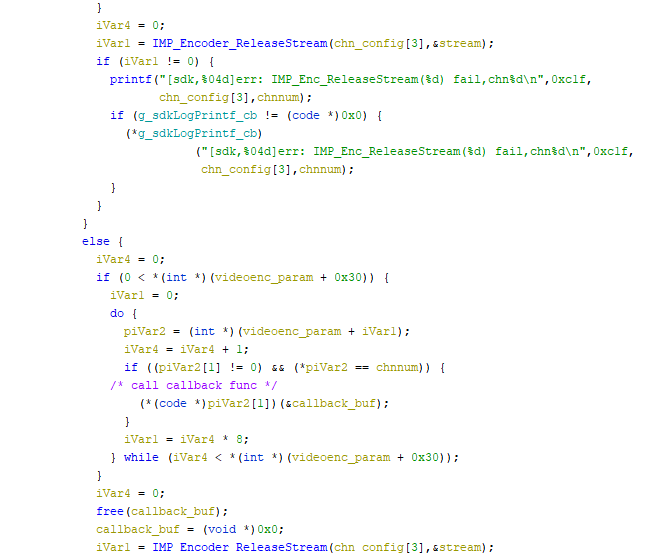

インストールできたら、JSON Configから以下のように設定します。

IPアドレスはお持ちのカメラに合わせてください。

{"cameras": [{"manufacturer": "honeylab","model": "atomcam","videoConfig": {"source": "-i rtsp://192.168.0.20:8554/unicast","maxStreams": 2,"maxWidth": 1920,"maxHeight": 1080,"maxFPS": 10,"maxBitrate": 300,"vcodec": "copy","mapvideo": "0","audio": false,"debug": true}}],}

この設定を行い、Homebridgeを再起動し、手持ちのiPhoneを該当のLANに接続しておきます。

iPhoneが接続できたら、HomebridgeのQRコードを「ホーム」アプリに読み込ませて連携させます(この辺は外部リンクを参照してください)

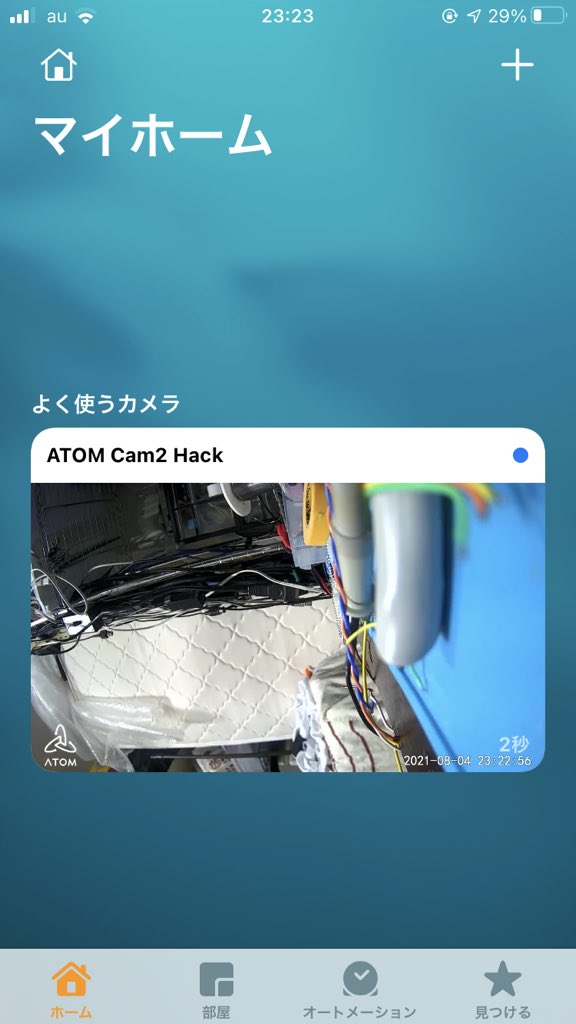

するとついに、iPhoneの「ホーム」アプリからカメラとして認識されました。

すごいすごい。

カメラの場所を「ガレージ」に設定したので、Siriに「ガレージのカメラを見せて」というと自動でこのカメラ画像を出してくれます。めっちゃ便利やん!!!

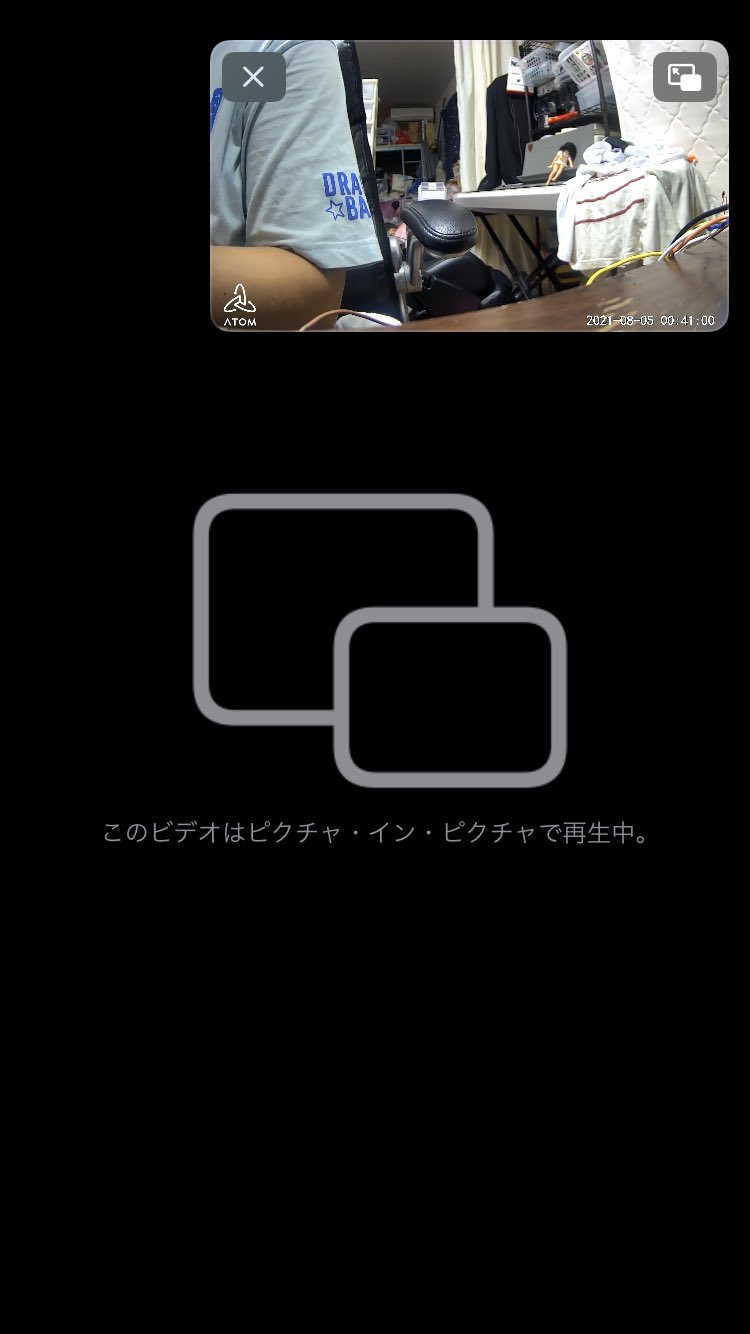

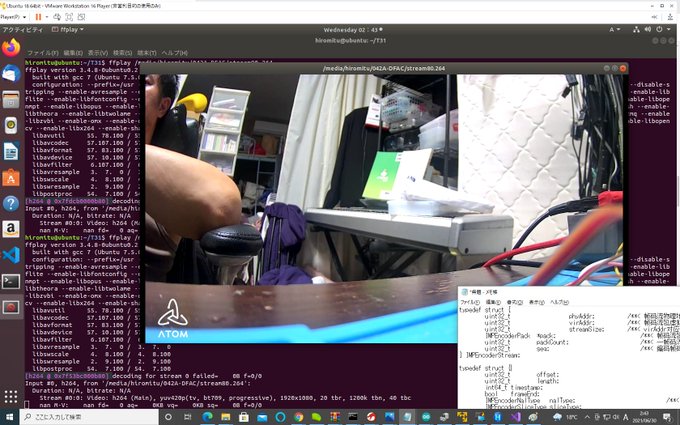

さらに、この画面でピクチャインピクチャとして表示させるようにすると…

おおおお!ピクチャインピクチャで普通に見れるじゃん!!便利!!!!

いや、思ったより簡単にできたわ。

で、RTSP対応は一番上のリンクの公式アナウンスにあるように一応公式実装されるので、それさえできればこのように自分のHomebridgeサーバを使って、AppleHomeKitに連携することはできるんじゃないかな…と思っています。

公式がお手上げしたのは、なにか、これより難しいNativeな構成や、商用対応が難しかったのでしょう。

ま、まだまだ遊べますね。